Фотографія Натаніеля Сент-Клера

Лікарні відмовляють у наданні психіатричної допомоги матерям, роботодавці використовують інструменти штучного інтелекту, які сприяють дискримінації на робочому місці, і «фантомні» нітрати у водопостачаннях призводять до хронічних захворювань у дітей. Ці занепокоєння звучать як історії, які Project Censored висвітлює у своєму щорічному звіті про найважливіші, але маловисвітлені новини.

Кожну з цих тем і дванадцять додаткових історій, подібних до них, звернув нашу увагу минулого червня суддя Project Censored Ніколас Джонсон. Автор Як переговорити з телевізором (1970) і Ваш другий пріоритет (2008) і колишній комісар Федеральної комісії зі зв’язку (1966–1973), Джонсон служив одним із суддів Project Censored, допомагаючи Проекту визначати та перевіряти щорічні записи найкращих «цензурних» історій кожного року з моменту заснування організації в 1976 році. Коли Нік зв’язується з нами з порадами щодо історії, ми звертаємо увагу.

Чат-бот ідентифікував ці новини після того, як Нік наказав йому надати п’ятнадцять прикладів «потенційно значущих новин, оприлюднених у публікаціях з невеликими тиражами, яким не приділяли увагу головні ЗМІ протягом минулого року», а також причини, чому цим історіям слід було приділяти більше уваги. Чат-боти, такі як ChatGPT від OpenAI і Gemini від Google, використовують генеративний штучний інтелект, щоб відповідати на запити користувачів за допомогою письмових або усних «розмов».

У той час співробітники Project Censored проводили наш власний огляд найкращих історій року, визначених студентами та їхніми наставниками факультету, які беруть участь у Програмі афілійованих студентських містечок Проекту, і перевірені колегією поважних суддів Проекту. Наш процес рецензування оповідань включає п’ять окремих етапів ретельної перевірки, щоб визначити важливість, своєчасність, якість джерел і, зрештою, надійність кожної історії-кандидата. Ці зусилля передбачають сотні годин людських зусиль, тож ми всі посміхнулися, коли надійшов електронний лист Ніка з підморгуючим привітанням: «Вибачте, що так пізно надіслав це вам, але моєму ШІ знадобилося щонайменше 15 секунд, щоб це зробити».

Ось один приклад зі списку історій, який Нік надіслав нам на основі відповіді його чат-бота:

«Розгортання безпілотного спостереження Walmart»

— Публікація: Щотижневий реєстр Plains (окружність ~4000)

— Scoop: витік місцевих угод про франшизу показує, що Walmart тестує патрулювання дронів зі штучним інтелектом у п’яти сільських штатах — без публічного повідомлення чи правил конфіденційності в повітрі.

— Чому це важливо: створено прецедент для комерційних дронів, які охороняють приватну власність — групи громадянських свобод повинні судитися, але історія загинула в регіоні.

Наприкінці свого звіту чат-бот підготував це аналітичне резюме:

Ці історії висвітлюють системні прогалини у висвітленні: коли національні ЗМІ зосереджуються на резонансних кризах, вони часто пропускають кризи, що назрівають у наших дворах: збої в місцевій інфраструктурі, нові загрози здоров’ю, нові виміри погіршення навколишнього середовища та стелс-вторгнення штучного інтелекту в повсякденне життя. Кожна історія мала не лише місцеві, а й національні (навіть глобальні) наслідки, і більш широка увага могла б стимулювати швидшу реакцію політики, регулювання чи охорони здоров’я.

Прочитавши це, ми були вражені. Цей абзац звучить так, ніби його можна було взяти з попереднього тому Проекту Стан вільної преси щорічник.

Можливо, в певному сенсі так і було.

Ми швидко визначили, що не лише всі «потенційно важливі» новини у списку чат-бота були сфабрикованими, але й усі п’ятнадцять нібито незалежних новинних організацій, яким приписують розкриття цих історій. Чат-бот все вигадав, але не розкриває, що він генерує вигадану інформацію, а не надає фактичні відповіді.

Щоб навчити набори даних для великих мовних моделей, таких як ChatGPT і Gemini, технічні розробники очищають Інтернет, каталогізуючи та витягуючи дані з усіх куточків Інтернету — часто без відома чи дозволу авторів, а тим більше без будь-якої фінансової компенсації. Теоретично список історій чат-бота, якими поділився Нік, міг бути змодельований за щорічним списком Топ-25 Project Censored, який архівується на веб-сайті проекту.

Але оскільки чат-боти, на відміну від Project Censored, не дотримуються керівних етичних принципів журналістики, таких як пошук правди, прозорість і підзвітність, мінімізуючи шкоду, вони просто імітують репортажі, які висвітлюють соціальну несправедливість, не розуміючи основного контексту, джерел або людського досвіду, які надають історіям, подібним до тих, які вони створюють, значення.

Чат-боти можуть відтворювати вигляд журналістських розслідувань, які, як правило, викривають корупцію, цензуру чи несправедливість, але їм бракує моральних і аналітичних рамок для належної перевірки фактів, оцінки мотивів і зважування потенційних наслідків своїх повідомлень. Селін Шрайбер Weave News описує це як «ризик тиражування без репрезентації: симулякр незалежної журналістики, якій бракує політичних чи громадських коренів».

Корпоративні медіа та технологічні компанії називають ці помилки «галюцинаціями» — коли системи штучного інтелекту буквально щось вигадують — термін, який водночас антропоморфізує ботів і применшує наслідки збереження неточностей — і те, і інше є звичайними підводними каменями звітів про ШІ. Розробники не зовсім знають, чому виникають галюцинації, тому у них немає способу їх зупинити.

«Попри всі наші зусилля, у них завжди будуть галюцинації», — сказав Амр Авадалла, виконавчий директор Vectara, стартапу, який створює інструменти ШІ для бізнесу, і колишній керівник Google. New York Times минулого травня. «Це ніколи не зникне».

У жовтні 2025 року BBC у партнерстві з Європейською мовною спілкою опублікувала масштабне дослідження, яке охопило двадцять дві суспільні медіа-компанії у вісімнадцяти країнах, згідно з якими помічники зі штучним інтелектом, такі як ChatGPT, Copilot і Gemini, «неправдиво подають» вміст новин приблизно в 45% випадків. Приблизно 31 відсоток відповідей, зібраних дослідниками, продемонстрували серйозні «проблеми з пошуком джерел — відсутня, оманлива або неправильна інформація», а близько 20 відсотків «містили серйозні проблеми з точністю». Як зазначив заступник генерального директора EBU Жан Філіп де Тендер, «ці недоліки не є поодинокими… Вони є системними, транскордонними та багатомовними, і ми вважаємо, що це ставить під загрозу суспільну довіру».

За даними Pew Research, хоча зараз порівняно небагато американців використовують чат-боти зі штучним інтелектом, такі як ChatGPT, для отримання інформації про новини, 42 відсотки тих, хто це використовує, повідомляють, що «їм загалом важко визначити, що правда, а що ні». Оскільки все більше користувачів звертаються до систем штучного інтелекту, а не до традиційних пошукових систем для пошуку інформації в Інтернеті, суспільство стикається з поглибленою кризою дезінформації, коли жадібність, конкурентний тиск і безконтрольне технологічне розширення продовжують підривати довіру суспільства до ЗМІ.

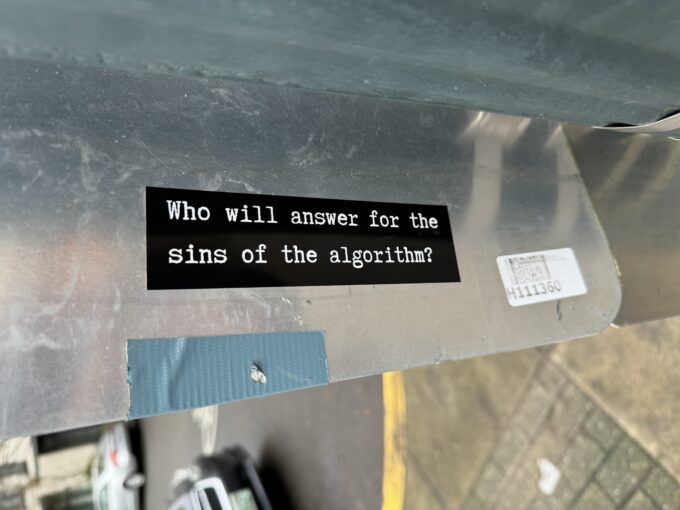

Нещодавні дослідження підтверджують потенційні можливості платформ соціальних мереж маніпулювати громадською думкою. Технічні компанії тепер контролюють інструменти для доступу до інформації та показники видимості, послідовно формуючи публічний дискурс. Громадська пильність і контроль є життєво важливими, оскільки штучний інтелект посилює свій контроль над нашою колективною реальністю.

«Історія» чат-бота Walmart, згадана вище, дуже нагадує справжню новину зі списку Project Censored найбільш цензурованих історій цього року – звіт якобінець про те, що Amazon і Walmart використовують технологію ворожого стеження за працівниками складу. Неймовірна схожість між сфабрикованим звітом чат-бота та якобінців real exposé підкреслює нагальну потребу в критичній медіаграмотності (CML), яка дає людям змогу не лише оцінювати достовірність конкретних медіа-повідомлень, але й розуміти динаміку влади, яка формує виробництво цих повідомлень.

Ця динаміка влади все частіше включає роль чат-ботів та інших систем на базі штучного інтелекту у фільтрації, блокуванні, а іноді й виготовленні інформації та перспектив, необхідних людям для отримання інформації та активної участі. Протягом п’ятдесяти років люди, які працюють з Project Censored — професори, студенти, медіа-науковці, ні машини—переглянули все більшу різноманітну низку незалежних джерел, щоб визначити, підтвердити та висвітлити важливі, але недооцінені новини. Відображаючи важливу роль вільної преси в діючій демократії, Project Censored залишається відданим служінню суспільному благу, а не приватним інтересам, викриваючи соціальні проблеми та надаючи людям можливість реагувати на них.

Критична медіаграмотність вимагає вивчення медіа на предмет їхньої потужності та призначення шляхом уважного розгляду власності, виробництва та розповсюдження. Ретельне дотримання цих слідів бореться з дезінформацією ШІ. Без CML, як свідчить список цензурованих історій чат-бота Ніка, інформацію, яку надає ШІ, стало важче відрізнити від правди.

Це вперше з’явилося на Project Censored.